本站4月18日消息,今日,騰訊混元宣布開源定制化圖像生成件InstantCharacter,并實現(xiàn)了對開源文生圖模型Flux的兼容。

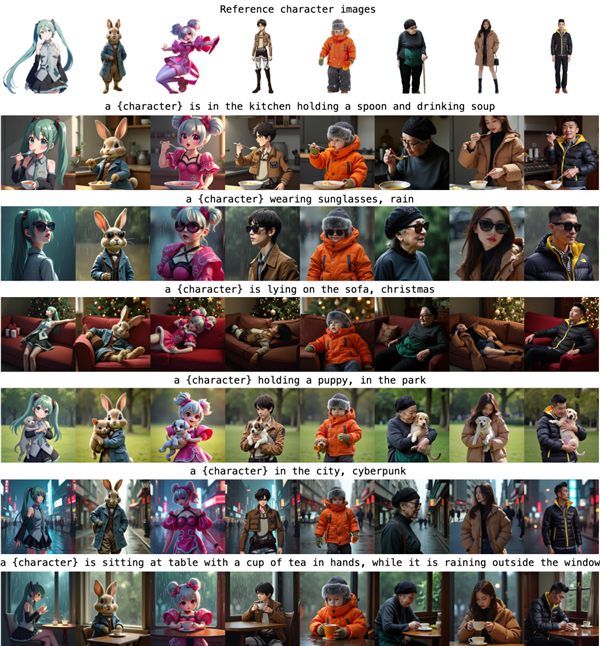

通過該插件,在大模型中,只需要一張圖加一句話,就能讓任何角色以你想要的姿勢出現(xiàn)在任何地方。

據(jù)介紹,InstantCharacter的優(yōu)勢在于可以確保角色在不同場景中的一致性和真實性、畫質(zhì)和精度高,同時具有靈活的文本編輯性,用戶可以根據(jù)需要靈活切換任意場景,讓人物生成任意動作。

因此,內(nèi)容創(chuàng)作者能通過這一插件讓生成的角色保持高度一致,能夠更高效地創(chuàng)作出符合其需求的視覺作品,可以用于連環(huán)畫、影片創(chuàng)作等場景。

輸入以下原始圖片:

prompt :a rabbit is in the kitchen holding a spoon and drinking soup,就能得到下面的圖:

prompt:a rabbit in the city,cyberpunk,就可以得到:

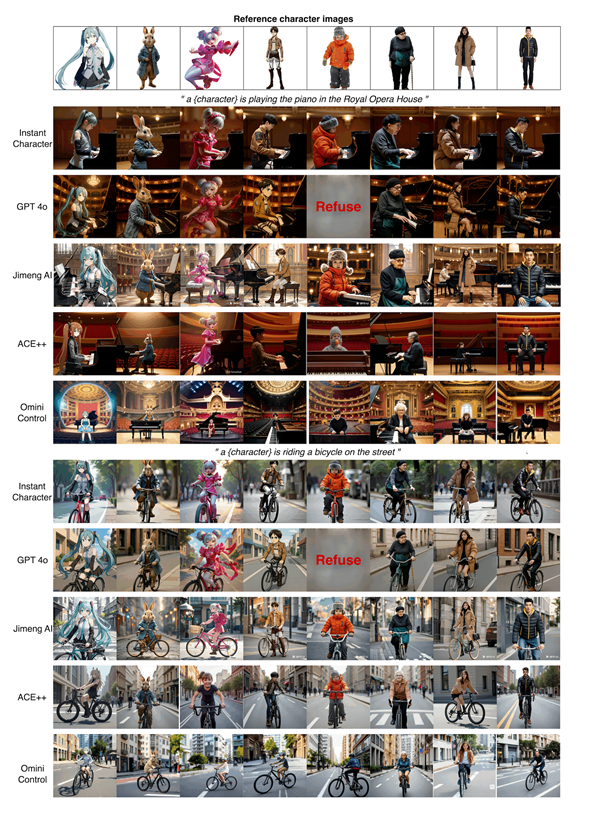

實際的測評中,開源的InstantCharacter實現(xiàn)的效果媲美GPT 4o等業(yè)界領(lǐng)先模型。

騰訊混元表示,現(xiàn)有基于學(xué)習(xí)的方法主要依賴于U-Net架構(gòu),但在泛化能力和圖像質(zhì)量上存在局限性,而基于優(yōu)化的方法則需要針對特定主體進行微調(diào),這不可避免地降低了文本可控性。

為解決這些問題,InstantCharacter利用DiT模型構(gòu)建了一個創(chuàng)新的框架。

框架引入一個可擴展的適配器(adapter),采用多個transformer encoder,能有效處理開放域的角色特征,并與現(xiàn)代擴散變換器的潛在空間無縫交互,這種設(shè)計使得系統(tǒng)能夠靈活適應(yīng)不同的角色特征。

鄭重聲明:本文版權(quán)歸原作者所有,轉(zhuǎn)載文章僅為傳播更多信息之目的,如作者信息標記有誤,請第一時間聯(lián)系我們修改或刪除,多謝。