千億參數(shù)內(nèi)最強(qiáng)推理大模型,剛剛易主了。

32B——DeepSeek-R1的1/20參數(shù)量;免費(fèi)商用;全面開源——模型權(quán)重、訓(xùn)練數(shù)據(jù)集和完整訓(xùn)練代碼,都開源了。

這就是剛剛亮相的Skywork-OR1 (Open Reasoner 1)系列模型——

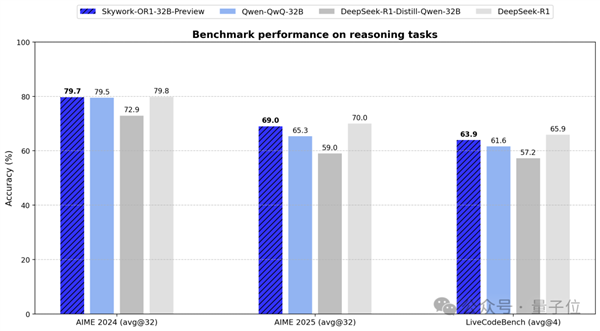

通用32B尺寸(Skywork-OR1-32B)完全超越同規(guī)模阿里QwQ-32B;代碼生成媲美DeepSeek-R1,但性價(jià)比更高。

△Skywork-OR1-32B-Preview

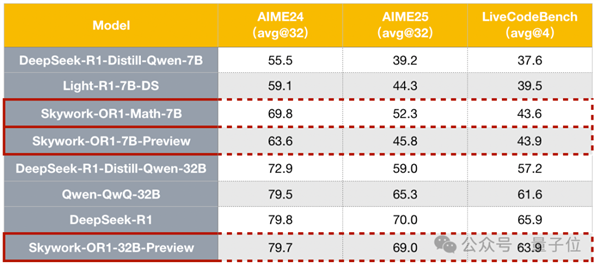

數(shù)學(xué)推理方面:7B、32B都達(dá)到同規(guī)模最優(yōu),數(shù)學(xué)專項(xiàng)模型(Skywork-OR1-Math-7B)表現(xiàn)更突出。

Skywork,天工是也,來自AIGC巨頭玩家昆侖萬維。

Skywork-OR1系列模型現(xiàn)已全面開源,模型權(quán)重、訓(xùn)練數(shù)據(jù)集和完整訓(xùn)練代碼,所有資源均已上傳至GitHub和Huggingface平臺。配套的技術(shù)博客已發(fā)布于Notion平臺,詳細(xì)闡述了數(shù)據(jù)處理流程、訓(xùn)練方法和關(guān)鍵技術(shù)發(fā)現(xiàn),為社區(qū)提供了完全可復(fù)現(xiàn)的實(shí)踐參考。

Skywork-OR1系列開源地址:https://github.com/SkyworkAI/Skywork-OR1(包含模型,代碼,數(shù)據(jù))

昆侖萬維天工團(tuán)隊(duì)更多開源項(xiàng)目:https://huggingface.co/Skywork

目前Skywork-OR1-7B和Skywork-OR1-32B的能力還在持續(xù)提升,在兩周內(nèi)會發(fā)布兩個模型的正式版本,同時(shí)也會推出更為系統(tǒng)詳盡的技術(shù)報(bào)告,分享推理模型訓(xùn)練中的經(jīng)驗(yàn)與洞察。

3款模型全量開源

Skywork-OR1 (Open Reasoner 1) 系列開源共有3款模型:

Skywork-OR1-Math-7B:專注數(shù)學(xué)領(lǐng)域的專項(xiàng)模型,同時(shí)也具有較強(qiáng)的代碼能力。

Skywork-OR1-7B-Preview:融合數(shù)學(xué)與代碼能力,兼顧通用與專業(yè)性。

Skywork-OR1-32B-Preview:面向高復(fù)雜度任務(wù)、具備更強(qiáng)推理能力的旗艦版本。

團(tuán)隊(duì)對比了Skywork-OR1系列在AIME24、AIME25、LiveCodeBench上的表現(xiàn)。

AIME24/25是美國數(shù)學(xué)邀請賽基準(zhǔn)測試,LiveCodeBench主要評估大語言模型代碼生成和編程能力。

在評測方面,Skywork-OR1系列模型引入avg@k作為核心評估指標(biāo),用于衡量模型在進(jìn)行k次嘗試時(shí)成功解決問題的平均表現(xiàn)。

傳統(tǒng)的pass@k指標(biāo)僅關(guān)注“至少一次成功”,相對而言avg@k更關(guān)注模型的穩(wěn)定性和整體推理能力,為模型實(shí)際落地提供更全面真實(shí)的參考。

在數(shù)學(xué)方面,通用模型Skywork-OR1-7B-Preview和Skywork-OR1-32B-Preview在AIME24與AIME25數(shù)據(jù)集上均實(shí)現(xiàn)了同參數(shù)規(guī)模下最優(yōu)表現(xiàn),32B整體表現(xiàn)基本與DeepSeek-R1齊平。

編程方面,通用模型Skywork-OR1-7B-Preview與Skywork-OR1-32B-Preview在LiveCodeBench上均取得了同等參數(shù)規(guī)模下的最優(yōu)性能。

整體而言,Skywork-OR1-32B-Preview甚至與DeepSeek-R1的差距非常微小。要知道后者的參數(shù)規(guī)模是前者的20倍,這意味著Skywork-OR1能帶來更具性價(jià)比的性能表現(xiàn)。

由此綜合來看,Skywork-OR1-32B-Preview成為當(dāng)前同規(guī)模最強(qiáng)中文推理模型,也是現(xiàn)役支持免費(fèi)商用的模型中最強(qiáng)且最具性價(jià)比的成員之一。

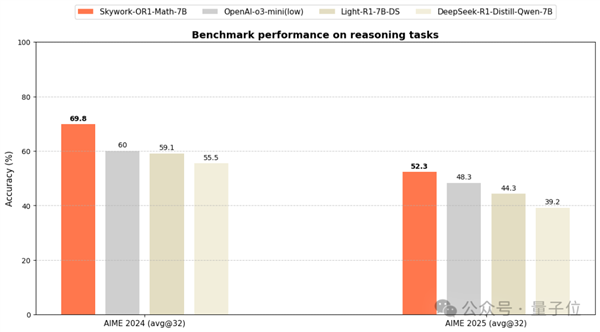

此外,數(shù)學(xué)專項(xiàng)模型Skywork-OR1-Math-7B在AIME24/25的表現(xiàn)遠(yuǎn)超當(dāng)前主流7B級模型,甚至接近蒸餾版Deepseek-32B模型同等水平(DeepSeek-R1-Distill-Qwen-32B)。

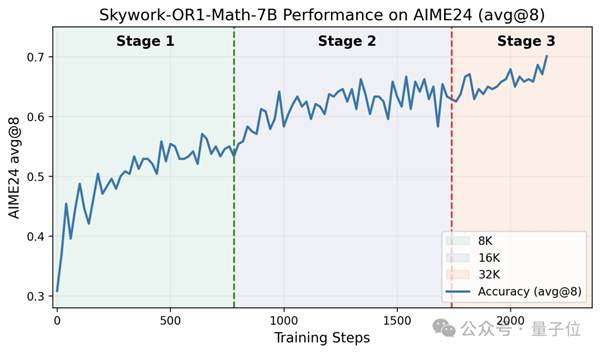

如下為該模型在AIME24上的訓(xùn)練準(zhǔn)確率曲線。

最終模型在AIME24和AIME25上分別達(dá)到69.8%和52.3%,超越了OpenAI-o3-mini (low),達(dá)到了當(dāng)前尺寸SOTA性能。與此同時(shí),該專項(xiàng)模型在代碼領(lǐng)域也表現(xiàn)出了較好的泛化性(訓(xùn)練后,Livecodebench從37.6%提升到43.6%)。

△OpenAI-o3-mini(low)的AIME24分?jǐn)?shù)來自官網(wǎng),AIME25分?jǐn)?shù)來自評測網(wǎng)站https://matharena.ai/

去年11月,昆侖萬維發(fā)布國內(nèi)首款中文復(fù)雜推理模型Skywork-o1,Skywork-OR1系列模型正是在此基礎(chǔ)上迭代而來。

不同于簡單復(fù)刻OpenAI o1模型,Skywork-o1內(nèi)生出了思考、計(jì)劃、反思等能力。它共包括三款模型Skywork-o1-Open、SI’m kywork-o1-Lite和Skywork-o1-Preview,分別適用于不同的應(yīng)用場景,可以滿足開源到高性能推理的多樣化需求。

Skywork-OR1系列站在Skywork-o1的肩膀上有了更強(qiáng)基座,但想要如此強(qiáng)大,也離不開一系列先進(jìn)技術(shù)加持。

背后秘訣:AGI技術(shù)洞藏,訓(xùn)練效率提升50%

Skywork-OR1在數(shù)據(jù)處理、訓(xùn)練策略等方面都做了進(jìn)一步創(chuàng)新。

首先在數(shù)據(jù)方面。

為提升模型在數(shù)學(xué)和代碼方面能力,Skywork-OR1構(gòu)建了一個高質(zhì)量數(shù)學(xué)和代碼數(shù)據(jù)集。

團(tuán)隊(duì)設(shè)計(jì)了三個標(biāo)準(zhǔn)進(jìn)行數(shù)據(jù)篩選:可驗(yàn)證性(Verifiable)、正確性(Correct)與挑戰(zhàn)性(Challenging),剔除無法自動驗(yàn)證的證明類題目、有誤題目、和缺少unit test的代碼問題。

數(shù)學(xué)領(lǐng)域共計(jì)收集11萬道題目,主要依賴NuminaMath-1.5(含約89.6萬題),選用如AIME和Olympiads等較難子集,并補(bǔ)充了如DeepScaleR、Omni-MATH、AIME 1983-2023難題來源。

代碼領(lǐng)域收集了13.7k條高質(zhì)量代碼問題,主要以LeetCode和TACO數(shù)據(jù)為主,保留了單元測試完整、驗(yàn)證通過的問題,并進(jìn)行向量級語義去重。

在數(shù)據(jù)過濾部分,團(tuán)隊(duì)對每道題進(jìn)行了多輪采樣并驗(yàn)證答案,以避免“全對”或“全錯”現(xiàn)象對策略學(xué)習(xí)無效——模型生成全部錯誤,無法提供有效的學(xué)習(xí)信號;“全對”意味著模型已完全掌握,繼續(xù)學(xué)習(xí)會浪費(fèi)計(jì)算資源。

并通過人類審核結(jié)合LLM自動判題機(jī)制,對語義不清、信息不全、格式錯誤或含有無關(guān)內(nèi)容的項(xiàng)目進(jìn)行清理。使用LLM-as-a-Judge剔除掉約1-2K道質(zhì)量不達(dá)標(biāo)的數(shù)學(xué)題。

其次在強(qiáng)化學(xué)習(xí)部分,Skywork-OR1使用GRPO(Group Relative Policy Optimization)進(jìn)行訓(xùn)練,并引入一系列優(yōu)化策略。

在訓(xùn)練時(shí)數(shù)據(jù)優(yōu)化上,一方面采用雙重過濾策略:

離線過濾:訓(xùn)練前使用待訓(xùn)練模型評估數(shù)據(jù),剔除正確率為0或1的樣本;在線過濾:每個epoch動態(tài)移除上一輪已完全掌握的數(shù)據(jù),確保模型持續(xù)面對有挑戰(zhàn)性的內(nèi)容。

另一方面使用拒絕采樣(Rejection Sampling)進(jìn)行更精細(xì)的實(shí)時(shí)篩選,在每個訓(xùn)練步驟中動態(tài)剔除當(dāng)前訓(xùn)練步中采樣正確率為0或1的樣本。這樣可以維持policy loss、entropy loss和KL loss的合理比例,防止非policy loss比重異常增加導(dǎo)致的訓(xùn)練不穩(wěn)定。

在訓(xùn)練Pipeline優(yōu)化上主要做了兩方面的探索。

(1)多階段訓(xùn)練(Multi Stage Training):

從小窗口開始,逐步增加上下文長度(seq_len),可以促使模型在有限token內(nèi)高效完成任務(wù);隨后逐步擴(kuò)展窗口大小,迭代增加生成長度,使模型逐漸掌握更復(fù)雜的長鏈思維能力。實(shí)驗(yàn)證明,多階段訓(xùn)練能顯著縮短訓(xùn)練時(shí)間,同時(shí)完全保持模型的長度擴(kuò)展能力。

(2)截?cái)鄡?yōu)勢掩碼(Truncated Advantage Mask):

在多階段訓(xùn)練初期,由于上下文窗口限制,復(fù)雜問題的回答可能被截?cái)唷R虼藞F(tuán)隊(duì)研究了兩種處理窗口限制下截?cái)鄻颖镜牟呗訟dv-Mask Before(計(jì)算優(yōu)勢前排除截?cái)鄻颖荆┖虯dv-Mask After(計(jì)算后將截?cái)鄻颖緝?yōu)勢置零)。證明即使不屏蔽截?cái)鄻颖荆P鸵材苡行нm應(yīng)并迅速提升性能,也證明多階段訓(xùn)練框架的魯棒性。

此外,在強(qiáng)化學(xué)習(xí)訓(xùn)練中還要保障模型的探索能力。

團(tuán)隊(duì)進(jìn)行了三方面探索。

第一,高溫度采樣。采用τ=1.0(高于常見的0.6)維持更高群組內(nèi)多樣性,既保證足夠正確樣本提供學(xué)習(xí)信號,又允許模型探索更廣泛解決路徑。

第二,提升內(nèi)在訓(xùn)練多樣性。通過精細(xì)數(shù)據(jù)過濾、增加批量大小和減少數(shù)據(jù)重復(fù)使用,可以從源頭上防止模型過早優(yōu)化到單一輸出方向,同時(shí)也保持較高熵值,避免局部最優(yōu)。

第三,自適應(yīng)熵控制。只有在熵值低于閾值時(shí)才提供熵增加鼓勵,設(shè)定目標(biāo)熵值并動態(tài)調(diào)整損失系數(shù),同時(shí)最小化對正常訓(xùn)練軌跡的干擾。

最后在保障強(qiáng)化學(xué)習(xí)訓(xùn)練的穩(wěn)定性,團(tuán)隊(duì)對損失函數(shù)進(jìn)行優(yōu)化。

第一,移除KL損失。研究中發(fā)現(xiàn)即使基于高質(zhì)量SFT模型訓(xùn)練,KL損失仍限制性能提升。因此,除特定階段外,團(tuán)隊(duì)在所有公開發(fā)布的Skywork-OR1系列模型中均未使用KL損失項(xiàng),這使模型能夠更充分地探索和優(yōu)化推理能力。

第二,token級策略損失。移除了策略損失中的長度歸一化項(xiàng),并將損失在訓(xùn)練批次內(nèi)的所有token上進(jìn)行平均,以提升優(yōu)化過程的一致性與穩(wěn)定性。

(更多技術(shù)細(xì)節(jié)和實(shí)驗(yàn)對比可以參照技術(shù)博客https://capricious-hydrogen-41c.notion.site/Skywork-Open-Reaonser-Series-1d0bc9ae823a80459b46c149e4f51680,或繼續(xù)關(guān)注后續(xù)發(fā)布的技術(shù)報(bào)告。)

在此訓(xùn)練策略下,Skywork-OR1-7B和Skywork-OR1-32B-Preview通用推理模型仍處于持續(xù)提升狀態(tài),本次開源是當(dāng)前訓(xùn)練過程中性能最佳的checkpoint。

預(yù)計(jì)兩周后,具備更全面能力提升及更強(qiáng)大推理能力的Skywork-OR1正式版本將與大家見面,同樣全面開源。

Hugging Face單月下載量超7萬

自2023年以來,在全面擁抱AIGC后,昆侖萬維一直堅(jiān)持開源,推動技術(shù)平權(quán)。代表性動作包括:

2023年:開源百億級大語言模型Skywork-13B系列及600GB高質(zhì)量數(shù)據(jù)集。2024年:陸續(xù)開源數(shù)字智能體研發(fā)工具包AgentStudio、4000億參數(shù)MoE超級模型、Skywork-MoE、 Skywork-RM/PRM,Skywork-o1。

今年以來,開源的頻率變得更高。第一季度開源動作包括:

面向AI短劇生成的視頻生成模型SkyReels-V1:下載量周榜前十R1V視覺思維鏈推理模型:單月下載8.75kSkywork-OR1新系列:長思維鏈推理模型。

不難發(fā)現(xiàn),昆侖萬維開源全面且徹底,同時(shí)兼顧產(chǎn)業(yè)需求。

一方面,它的基礎(chǔ)模型布局非常全面,覆蓋AIGC全領(lǐng)域,文生文、文生視頻、文生音樂等。

另一方面,這些模型從底層設(shè)計(jì)上即考慮了實(shí)際落地的需求。提供更高性價(jià)比、更節(jié)省算力,如SkyReels-V1則是看到了垂直領(lǐng)域的落地前景,模型下載量迅速增長也驗(yàn)證了這一市場需求。

最關(guān)鍵的是,這些模型的開源程度也相當(dāng)徹底,十分利于開發(fā)者使用。

在Hugging Face上,昆侖萬維開源模型的下載量相當(dāng)可觀,累計(jì)上月下載量超過7萬。

△部分展示

如今,底層模型競爭日趨白熱化,全球AI領(lǐng)域正以驚人的速度迭代演進(jìn),幾乎每個月都有值得關(guān)注的模型發(fā)布,這種創(chuàng)新密度前所未有。

作為國內(nèi)最早All in AIGC賽道的先行者之一,昆侖萬維自2023年起便構(gòu)建了全方位的前沿布局:從基礎(chǔ)大模型到垂直應(yīng)用,從技術(shù)研發(fā)到生態(tài)建設(shè)。尤其值得注意的是,昆侖萬維持續(xù)為開發(fā)者社區(qū)提供高質(zhì)量的模型和工具鏈,這種堅(jiān)持普惠的技術(shù)理念也為其提供了獨(dú)特競爭力。

當(dāng)前,開源生態(tài)正展現(xiàn)出前所未有的活力。

這些開源創(chuàng)新正快速滲透到互聯(lián)網(wǎng)、制造業(yè)、醫(yī)療、教育等領(lǐng)域,推動著AI技術(shù)真正實(shí)現(xiàn)規(guī)模化落地。在這一進(jìn)程中,以昆侖萬維為代表的開源踐行者的每一步探索,都將深刻影響AI產(chǎn)業(yè)的發(fā)展軌跡。

據(jù)說Skywork-OR1正式版,也已經(jīng)快馬加鞭,即將對外發(fā)布。

Skywork開源系列(2025)傳送門:

1、中文推理模型Skywork-OR1:

https://github.com/SkyworkAI/Skywork-o1

2、視覺思維鏈推理模型Skywork-R1V:

https://github.com/SkyworkAI/Skywork-R1V

3、AI短劇生成模型SkyReels-V1:

https://github.com/SkyworkAI/SkyReels-V1

鄭重聲明:本文版權(quán)歸原作者所有,轉(zhuǎn)載文章僅為傳播更多信息之目的,如作者信息標(biāo)記有誤,請第一時(shí)間聯(lián)系我們修改或刪除,多謝。